如何运行 Ollama 并加载 DeepSeek-R1 蒸馏模型

随着本地模型推理逐渐普及,Ollama 凭借其简洁的模型管理和运行方式,成为不少开发者优先选择的工具之一。本篇文章将介绍如何在国内网络环境中手动安装 Ollama,并在一台单卡 Nvidia V100 服务器上运行 DeepSeek-R1 模型(蒸馏版),并通过 nvtop 实时查看显卡资源变化。

一、准备工作

1. 手动下载 Ollama 安装包(需科学上网)

由于国内网络环境限制,直接访问 Ollama GitHub 仓库 可能存在困难或速度很慢。推荐使用科学上网工具,手动从以下链接下载对应系统的安装包:

- 访问链接:https://github.com/ollama/ollama/releases

- 找到适合你系统的

.tar.gz或.deb文件(以 Linux x86_64 为例) 或按照 Linux 安装指南 手动下载安装包

下载完成后,务必使用 sha256sum 校验完整性:

sha256sum ollama-linux-amd64.tgz

对比 GitHub 上提供的 SHA 值,确保一致。

2. 准备服务器:单卡 V100 GPU

本文使用具备 Nvidia V100 显卡的服务器,由于 V100 有 32G 显存,可以覆盖到 DeepSeek R1 量化版 32b 蒸馏模型:

- 系统:Ubuntu 20.04+

- GPU:Nvidia V100 32GB

- 驱动要求:CUDA 11.x 或以上

- 依赖:Nvidia Container Toolkit

创建服务器后,建议更新系统并安装基本工具:

sudo apt update && sudo apt upgrade -y

二、安装 Ollama

3. 将安装包拷贝到服务器

使用 scp 工具从本地将安装包上传到 V100 服务器:

scp ollama-linux-amd64.tgz user@server-ip:/home/user/

或使用服务器自带的 JupyterLab(大多数 GPU 云厂商都预置此工具)文件上传功能。

上传完成后,在服务器端再次校验完整性:

sha256sum ollama-linux-amd64.tgz

4. 解压并检查 GPU 支持

解压并查看 /usr/lib/ollama 下是否正确安装了 GPU 所需库:

sudo tar -C /usr -xzf ollama-linux-amd64.tgz

ls /usr/lib/ollama

确认存在如 libggml-cuda.so 等文件。

5. 启动 Ollama Server

ollama serve

三、运行 DeepSeek-R1 蒸馏版模型

6. 拉取模型

使用以下命令拉取蒸馏版本的模型:

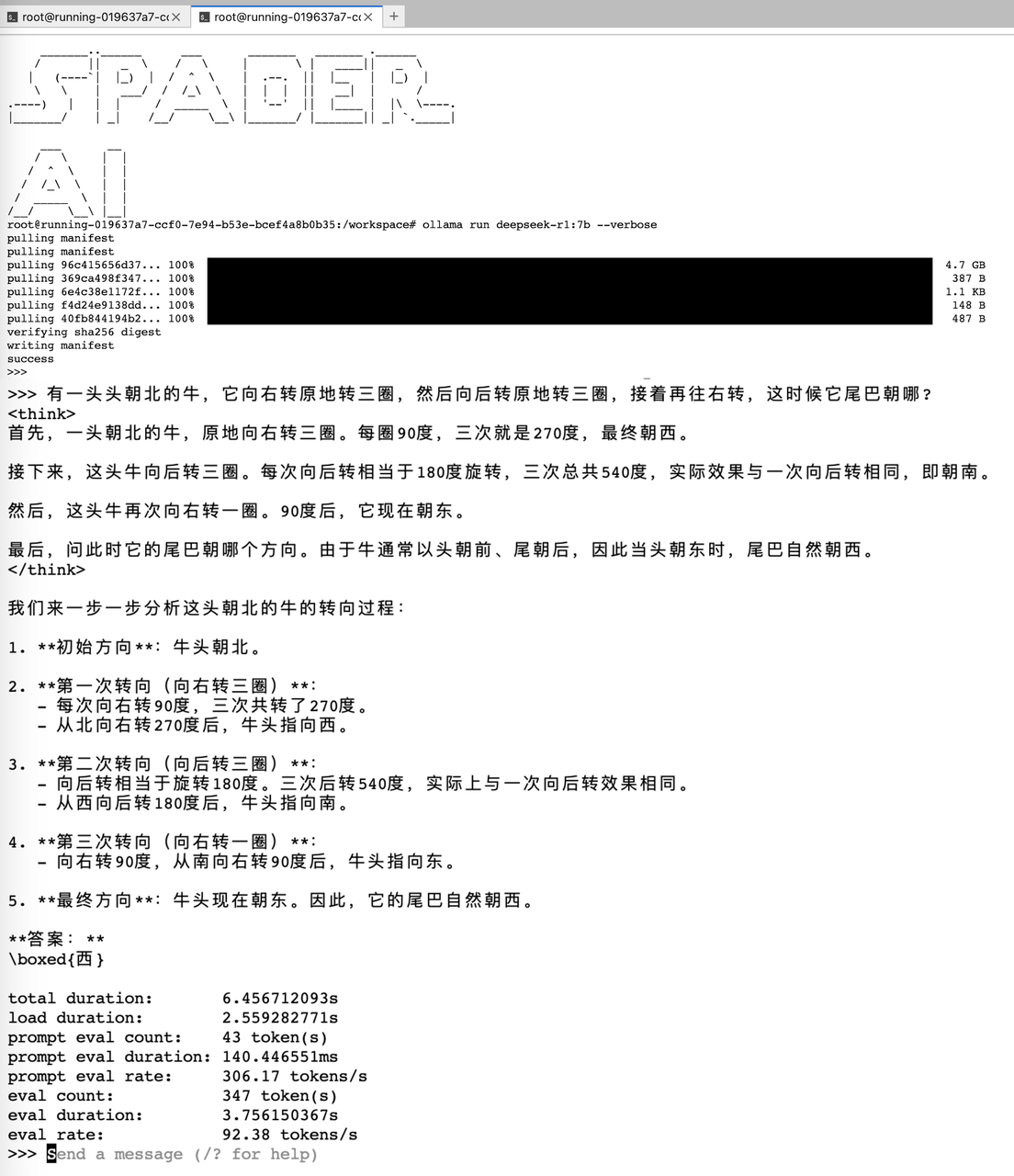

ollama run deepseek-r1:7b [--verbose]

初次运行会下载模型权重并缓存至本地,耐心等待。

下载完毕可以体验一下模型:

四、监控 GPU 使用情况

7. 安装 nvtop

在另一个终端窗口中,运行以下命令安装 GPU 资源监控工具:

sudo apt install nvtop

8. 实时查看资源变化

运行以下命令打开监控界面:

nvtop

你将看到 GPU 使用率、温度、功耗和显存占用的实时信息。

五、显存需求参考

以下为 DeepSeek-R1 模型页面 中提供的不同量化版本对显存的实际测试需求:

| 模型版本 | 显存需求(约) | 模型大小(约) | eval rate (tokens/s) |

|---|---|---|---|

| deepseek-r1:1.5b | 2GB | 1.1GB | 145 |

| deepseek-r1:7b | 5.6GB | 4.7GB | 90 |

| deepseek-r1:8b | 6.4GB | 4.9GB | 89 |

| deepseek-r1:14b | 11GB | 9GB | 52 |

| deepseek-r1:32b | 21GB+ | 19GB | 29 |

顺便测了一下模型 deepseek-r1:7b 在其它显卡上的性能如下:

| 显卡 | eval rate (tokens/s) |

|---|---|

| A100 | 103 |

| V100 | 90 |

| T4 | 36 |

注意:模型显存需求与上下文长度和并发请求数也有关系,以上为单次推理的数值。

总结

通过手动下载和部署 Ollama,即使在国内网络环境中,我们依然可以高效运行诸如 DeepSeek-R1 这样的开源模型。借助 V100 GPU,我们能够轻松测试多种模型版本,探索本地大模型推理的新可能。

如果你也尝试了其他模型,欢迎联系我们分享你的显卡配置与加载效果!